机器学习-白板推导 3. 线性回归

机器学习-白板推导 3. 线性回归

1. 线性回归矩阵表示

假定数据集:

数据矩阵为:(这样可以保证每一行为一个数据点)

设拟合的函数为:

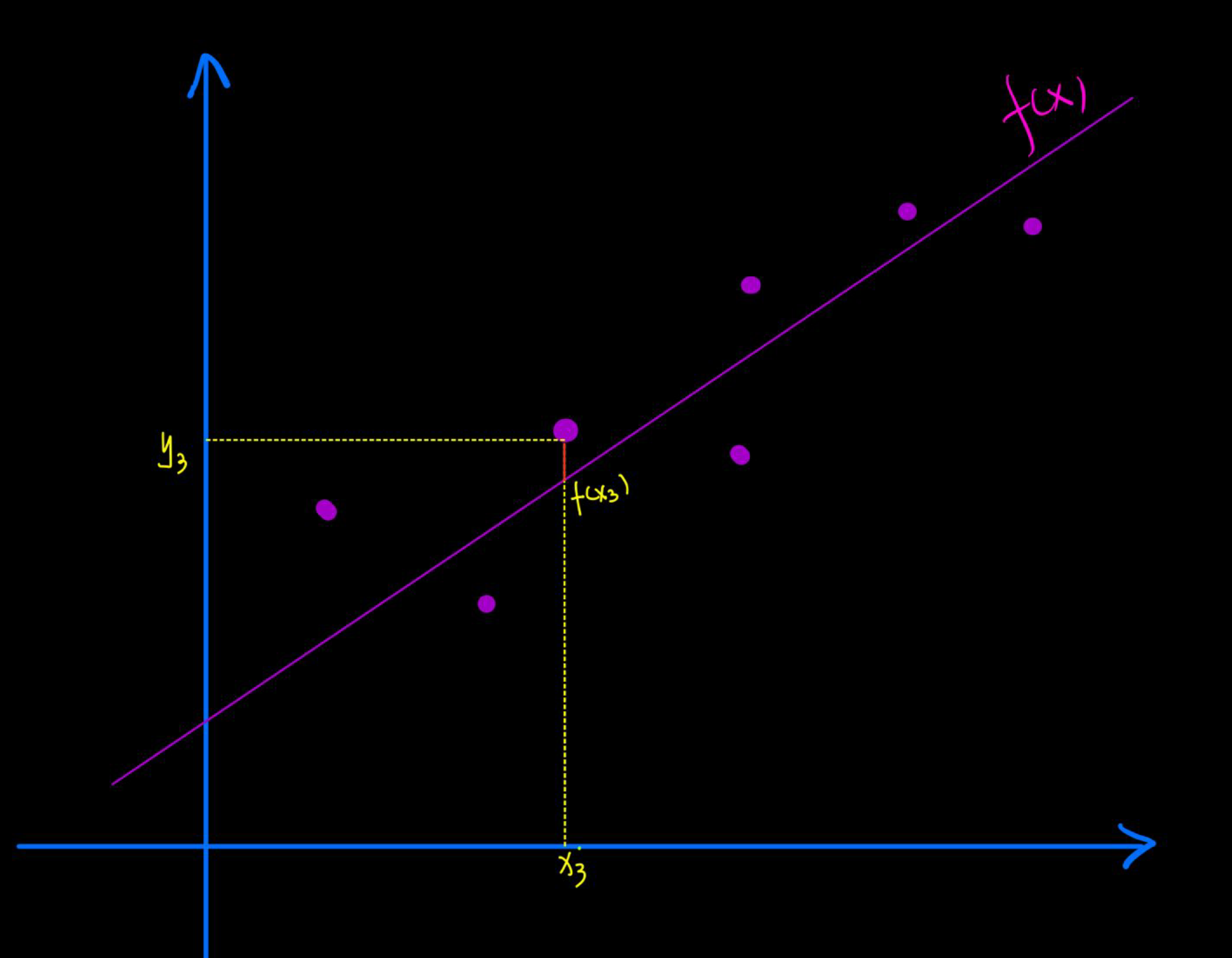

如下图所示,

对于每个样本点,比如的残差就是红色部分的距离:.因此总的损失为:

写成矩阵形式就是:

对 求导得:

这里要求满秩,也就是是满秩的即矩阵列向量都是独立的,即特征列都不相关。

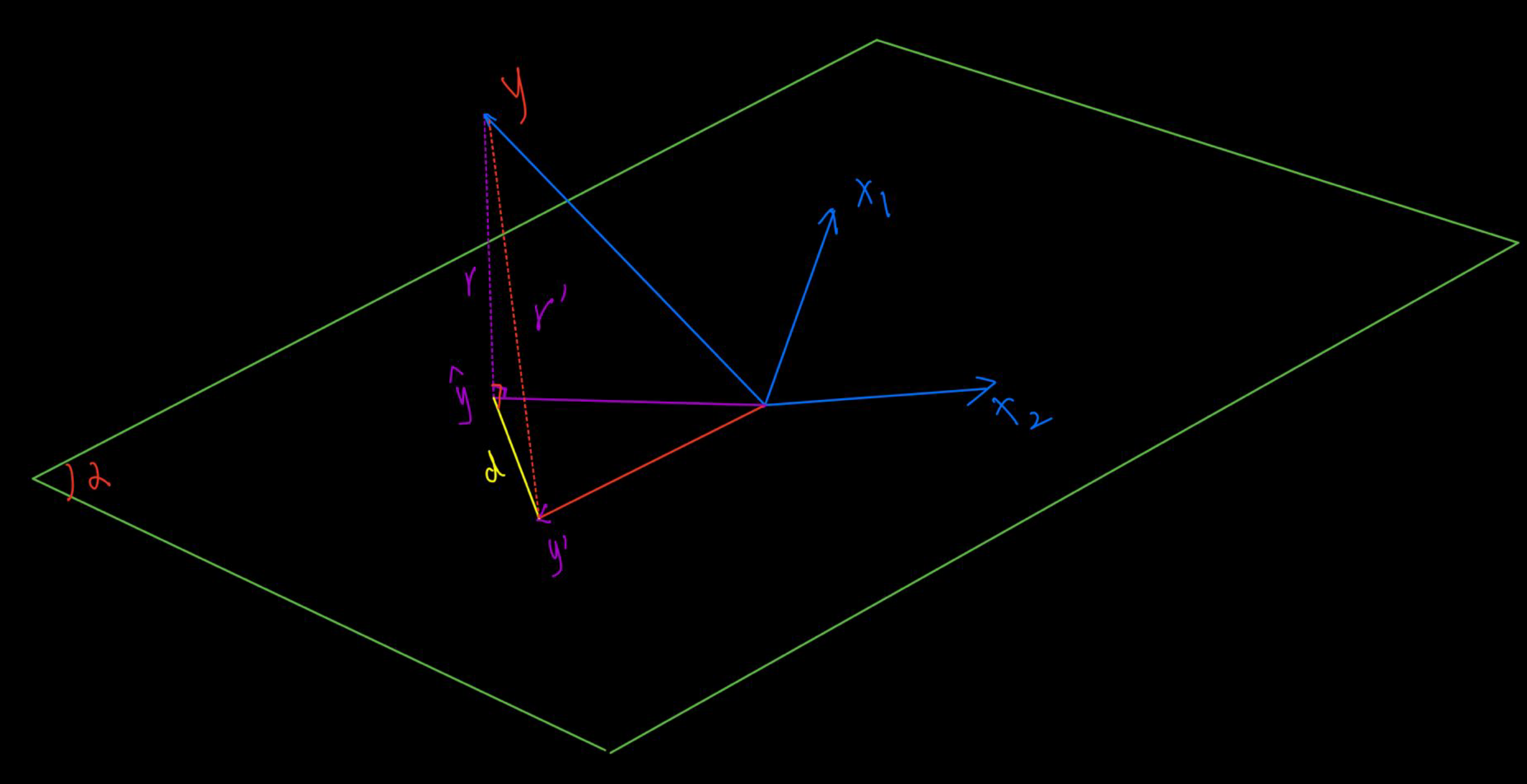

2. 最小二乘估计的几何意义

如上图,假设样本张成空间为平面。 那么其通过拟合得到的函数为:

当我们拟合得到的正好是真实值在平面内的投影时,可以使得d最小。即那么有:

因此.

3. 从概率视角看最小二乘法

假设, 其中。那么有。在该条件下,目标是求使得观察值出现的概率最大,使用MLE求解下式:

即对于每个样本都能式上面概率最大:

因此,只要最大即可。这与矩阵求解表达式一样,因此,最小二乘法隐含着一个条件,噪声符合高斯分布。

4. 正则化

对损失函数正则化后,表达式变为。

- Lasso,其中

- Ridge,岭回归,也就是

岭回归频率派角度

损失函数改写为

然后 对求导得:

可得:

这里,因为是半正定矩阵, 必然可逆。

岭回归Bayes估计角度

根据第3小节所说, 可以得到 :

目标是求的最大后验估计MAP, 也就是。由bayes公式得:

因为是由数据集给定的,可以看做常量,再加入对数操作简化计算,可以简化成:

即:

因为与 最大化无关,可以舍去,即:

进一步简化的:

这样跟从频率角度得到的岭回归结果一样。即最小二乘估计中隐藏一个假设:噪声服从高斯分布。即正则化的最小二乘法等价于最大后验估计MAP,其中噪声为高斯分布,并且假定也服从高斯分布。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 aigonna!

评论